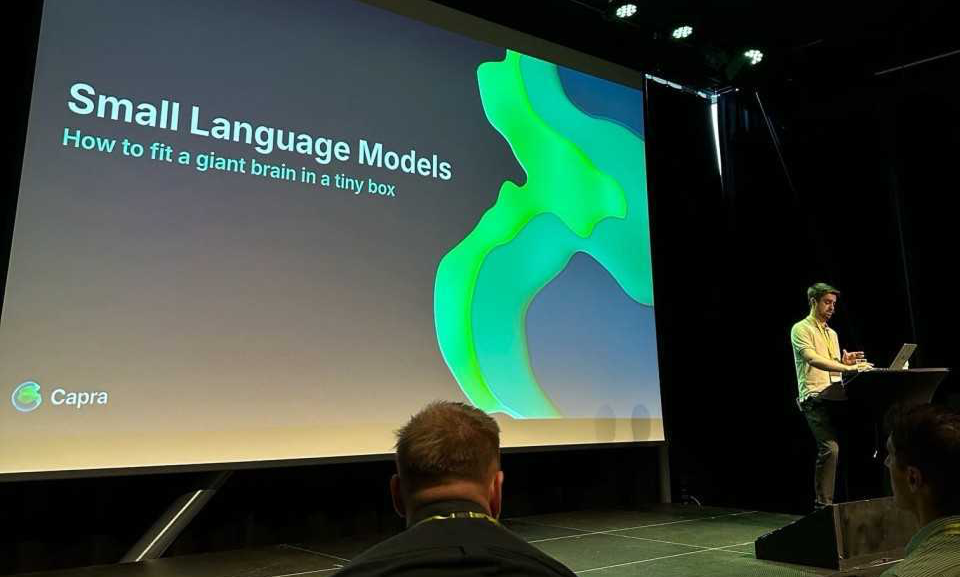

I en verden som i økende grad tar i bruk AI-tjenester i hverdagen, blir spørsmål om personvern og miljøpåvirkning stadig viktigere. Store språkmodeller (LLM-er) tilbyr kraftige løsninger, men kommer med betydelige utfordringer knyttet til datasikkerhet og høye karbonutslipp under både trening og inferens. På TDC 2025 i Trondheim holdt Vemund Santi foredrag om komprimering av språkmodeller. Det ble et dypdykk i hvordan vi kan redusere størrelsen på språkmodeller ved å komprimere dem til mindre versjoner – små nok til å kjøre lokalt på en laptop eller til og med en telefon. Fikk du ikke vært der? Ikke fortvil! Du finner opptak av foredraget nederst i denne saken og du får en oppsummering av foredraget her:

Vemund dekket både den teoretiske bakgrunnen og praktiske metoder for å jobbe med komprimerte modeller. To hovedteknikker var fokus:

Dette åpner for helt nye muligheter: AI-assistanse som ikke sender sensitiv kode eller data ut av huset, og tjenester som fungerer selv uten internettforbindelse.

Den økende bruken av AI-tjenester krever stadig mer energi. Nye arkitekturer som Mixture of Experts-modeller viser at industrien tar utfordringen på alvor, men å kunne kjøre modeller lokalt gir oss som utviklere flere verktøy i verktøykassen. Det handler ikke bare om miljø, men også om:

Vemund har tidligere skrevet om temaet i Kode24 og holdt workshops om lokale AI-modeller hos Capra. Med sin bakgrunn fra både større bedrifter og mindre startups i Norge og Silicon Valley, kombinerer han bred erfaring med dyp teknisk innsikt. Vil du vite mer om hvordan du selv kan komme i gang med lokale AI-modeller? Ta kontakt, så deler vi gjerne erfaringer og ressurser!

obr@capraconsulting.no

+47 971 20 556